serg_sk

Пользователи-

Публикации

96 -

Зарегистрирован

-

Посещение

Все публикации пользователя serg_sk

-

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

net.isr попробую. Но надо включить ему несколько потоков) -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Прибито, правила причесаны. -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Очереди сетевух сжирают весь процессор. Что можно предпринять? PMC: [iNSTR_RETIRED_ANY] Samples: 191930 (100.0%) , 0 unresolved %SAMP IMAGE FUNCTION CALLERS 27.1 kernel __mtx_lock_sleep dummynet_io 10.6 kernel ipfw_chk ipfw_check_packet 7.6 kernel fsk_match dn_ht_find 5.5 kernel rn_match ipfw_lookup_table:4.7 rtalloc1_fib:0.8 3.3 libc.so.7 bsearch 0x6564 2.8 kernel __rw_rlock in_localip:0.5 ipfw_chk:0.5 2.4 kernel bcmp pf_find_state 2.0 kernel _rw_runlock_cookie in_localip 1.8 pf.ko pf_test pf_check_in:1.0 pf_check_out:0.8 1.8 kernel bzero ipfw_check_packet 1.5 kernel dn_ht_find dummynet_io 1.1 kernel murmur3_aligned_32 pf_find_state 1.1 pmcstat 0x657c bsearch 1.0 kernel ip_fastforward ether_demux 0.9 kernel bcopy m_copydata 0.8 kernel ipfw_lookup_table ipfw_chk 0.8 kernel dummynet_io ipfw_check_packet 0.8 pf.ko pf_change_ap 0.7 kernel ixgbe_rxeof ixgbe_msix_que 0.7 pf.ko pf_test_rule pf_test 0.7 pmcstat 0x6591 bsearch 0.7 pf.ko pf_test_state_tcp pf_test 0.7 kernel ipfw_lookup_dyn_rule ipfw_chk 0.6 kernel strncmp iface_match 0.6 pf.ko pf_match_translation pf_get_translation 0.6 kernel ixgbe_xmit ixgbe_mq_start_locked 0.6 kernel bounce_bus_dmamap_lo bus_dmamap_load_mbuf_sg 0.6 kernel ether_nh_input netisr_dispatch_src 0.5 kernel uma_zalloc_arg 0.5 kernel rtalloc1_fib rtalloc_ign_fib last pid: 85063; load averages: 8.39, 7.77, 7.41 up 2+06:35:16 21:46:13 187 processes: 21 running, 121 sleeping, 45 waiting CPU: 0.0% user, 0.0% nice, 5.4% system, 84.8% interrupt, 9.7% idle Mem: 24M Active, 150M Inact, 1085M Wired, 1655M Buf, 30G Free Swap: PID USERNAME PRI NICE SIZE RES STATE C TIME CPU COMMAND 12 root -92 - 0K 832K CPU3 3 24.1H 100.00% intr{irq278: ix0:q2} 12 root -92 - 0K 832K CPU4 4 24.6H 98.88% intr{irq279: ix0:q3} 12 root -92 - 0K 832K CPU2 2 25.0H 98.58% intr{irq277: ix0:q1} 12 root -92 - 0K 832K CPU1 1 24.8H 98.10% intr{irq276: ix0:q0} 12 root -92 - 0K 832K CPU5 5 24.5H 97.56% intr{irq280: ix0:q4} 11 root 155 ki31 0K 128K RUN 0 41.6H 96.48% idle{idle: cpu0} 12 root -92 - 0K 832K CPU7 7 24.6H 96.48% intr{irq282: ix0:q6} 12 root -92 - 0K 832K CPU6 6 24.0H 95.65% intr{irq281: ix0:q5} 14916 root 20 -15 96012K 40904K nanslp 0 219:17 6.05% perl 11 root 155 ki31 0K 128K RUN 3 29.8H 5.37% idle{idle: cpu3} 11 root 155 ki31 0K 128K RUN 6 29.9H 3.37% idle{idle: cpu6} 11 root 155 ki31 0K 128K RUN 7 29.4H 2.49% idle{idle: cpu7} 11 root 155 ki31 0K 128K RUN 5 29.5H 1.56% idle{idle: cpu5} 11 root 155 ki31 0K 128K RUN 1 29.2H 1.07% idle{idle: cpu1} 11 root 155 ki31 0K 128K RUN 2 29.0H 0.98% idle{idle: cpu2} 11 root 155 ki31 0K 128K RUN 4 29.3H 0.29% idle{idle: cpu4} 14 root -16 - 0K 16K - 6 23:36 0.10% rand_harvestq 0 root -16 - 0K 560K swapin 0 244.4H 0.00% kernel{swapper} 0 root -92 - 0K 560K CPU0 0 711:46 0.00% kernel{dummynet} -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Где-то в гугле нашел. Правда там до 4000 поднимали, но я пошел дальше для тестов :) P.S. При kern.hz = 1000 Удалось прокачать 3.7Г трафа. Но это еще не предел, больше не было. Можно еще немного абонов занатить :) -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Установил в 1000. Будем проверять. Вообще не критично :) -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

В каком смысле перекос? Выставить можно, надо пробовать ) -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

-

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

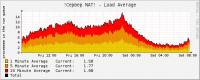

Итак. Игры с тюнингом без выключения HT и вытаскиванием проца помогли вытащить 2.5Г трафа максимум. Дальше был отключен HT, стало немного лучше, но не совсем. Потом конфигурация с 8гигабитными сетевухами была заменена на карту в 10Г. И одновременно был вытащен второй процессор. В идеале надо было делать по очереди, чтобы ощутить разницу. Вначале все равно немного не стабильно работало. dummynet жрал как не всебя много. Но установка kern.hz=4000 (было 8000) дала свои результаты. Итого имеем 3.4Гтрафа, load average держится около 5.00. Графики и вывод top постараюсь потом добавить при таких параметрах. А сейчас 1.7Г трафа: last pid: 95967; load averages: 2.54, 2.62, 2.47 up 1+00:26:00 09:45:15 178 processes: 10 running, 117 sleeping, 51 waiting CPU: 0.0% user, 0.0% nice, 3.1% system, 32.1% interrupt, 64.9% idle Mem: 22M Active, 90M Inact, 1044M Wired, 1656M Buf, 30G Free Swap: PID USERNAME PRI NICE SIZE RES STATE C TIME CPU COMMAND 11 root 155 ki31 0K 128K RUN 0 17.2H 99.02% idle{idle: cpu0} 11 root 155 ki31 0K 128K RUN 5 983:00 73.97% idle{idle: cpu5} 11 root 155 ki31 0K 128K CPU1 1 976:17 73.29% idle{idle: cpu1} 11 root 155 ki31 0K 128K RUN 6 997:04 72.66% idle{idle: cpu6} 11 root 155 ki31 0K 128K CPU7 7 996:03 72.56% idle{idle: cpu7} 11 root 155 ki31 0K 128K RUN 3 975:00 72.27% idle{idle: cpu3} 11 root 155 ki31 0K 128K CPU4 4 990:58 70.95% idle{idle: cpu4} 11 root 155 ki31 0K 128K CPU2 2 976:02 68.02% idle{idle: cpu2} 12 root -92 - 0K 832K WAIT 2 470:55 32.32% intr{irq277: ix0:q1} 12 root -92 - 0K 832K WAIT 5 463:16 32.03% intr{irq280: ix0:q4} 12 root -92 - 0K 832K CPU1 1 469:56 31.93% intr{irq276: ix0:q0} 12 root -92 - 0K 832K WAIT 4 454:54 31.84% intr{irq279: ix0:q3} 12 root -92 - 0K 832K WAIT 7 449:42 31.49% intr{irq282: ix0:q6} 12 root -92 - 0K 832K WAIT 6 448:32 31.05% intr{irq281: ix0:q5} 12 root -92 - 0K 832K WAIT 3 471:53 29.25% intr{irq278: ix0:q2} 1794 root 20 -15 96012K 39080K nanslp 5 97:07 3.32% perl 0 root -92 - 0K 560K - 0 414:00 2.83% kernel{dummynet} 0 root -16 - 0K 560K swapin 2 46.6H 0.00% kernel{swapper} 14 root -16 - 0K 16K - 7 10:34 0.00% rand_harvestq 3 root -16 - 0K 16K pftm 0 4:21 0.00% pf purge 23074 root 20 0 21948K 3336K CPU7 7 1:13 0.00% top 1648 root 20 0 67184K 10572K select 1 1:11 0.00% snmpd 0 root -92 - 0K 560K - 6 0:53 0.00% kernel{ix0:q0} 0 root -92 - 0K 560K - 1 0:50 0.00% kernel{ix0:q3} 0 root -92 - 0K 560K - 5 0:50 0.00% kernel{ix0:q5} 0 root -92 - 0K 560K - 2 0:48 0.00% kernel{ix0:q4} 0 root -92 - 0K 560K - 6 0:48 0.00% kernel{ix0:q2} 0 root -92 - 0K 560K - 7 0:46 0.00% kernel{ix0:q1} 0 root -92 - 0K 560K - 2 0:46 0.00% kernel{ix0:q6} Попробуем апнуть 4+гига ) -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Было сделано. 1. dummynet прибит на CPU0 2. Уменьшено количество очередей на сетевых картах до 2. 3. irq сетевух раскинул по ядрам от 16 до 31. 4. sysctl net.isr.dispatch=direct Вот показатели при трафике +- 2.2Гига. last pid: 84157; load averages: 7.58, 6.91, 7.33 up 0+14:23:37 21:58:08 272 processes: 47 running, 138 sleeping, 1 zombie, 86 waiting CPU: 0.0% user, 0.0% nice, 3.1% system, 18.3% interrupt, 78.6% idle Mem: 28M Active, 107M Inact, 942M Wired, 768K Cache, 265M Buf, 61G Free Swap: PID USERNAME PRI NICE SIZE RES STATE C TIME CPU COMMAND 11 root 155 ki31 0K 512K CPU4 4 740:23 100.00% idle{idle: cpu4} 11 root 155 ki31 0K 512K CPU2 2 738:52 100.00% idle{idle: cpu2} 11 root 155 ki31 0K 512K CPU3 3 738:25 100.00% idle{idle: cpu3} 11 root 155 ki31 0K 512K CPU7 7 737:34 100.00% idle{idle: cpu7} 11 root 155 ki31 0K 512K RUN 10 736:50 100.00% idle{idle: cpu10} 11 root 155 ki31 0K 512K CPU13 13 736:27 100.00% idle{idle: cpu13} 11 root 155 ki31 0K 512K CPU5 5 735:04 100.00% idle{idle: cpu5} 11 root 155 ki31 0K 512K CPU15 15 731:08 100.00% idle{idle: cpu15} 11 root 155 ki31 0K 512K CPU9 9 731:06 100.00% idle{idle: cpu9} 11 root 155 ki31 0K 512K CPU8 8 730:06 100.00% idle{idle: cpu8} 11 root 155 ki31 0K 512K CPU12 12 729:19 100.00% idle{idle: cpu12} 11 root 155 ki31 0K 512K CPU11 11 728:47 100.00% idle{idle: cpu11} 11 root 155 ki31 0K 512K CPU14 14 718:12 100.00% idle{idle: cpu14} 11 root 155 ki31 0K 512K CPU1 1 725:30 99.32% idle{idle: cpu1} 11 root 155 ki31 0K 512K CPU6 6 735:14 99.22% idle{idle: cpu6} 0 root -92 - 0K 432K CPU0 0 185:58 98.39% kernel{dummynet} 11 root 155 ki31 0K 512K CPU25 25 584:44 73.14% idle{idle: cpu25} 11 root 155 ki31 0K 512K CPU29 29 579:52 72.31% idle{idle: cpu29} 11 root 155 ki31 0K 512K CPU26 26 582:24 72.07% idle{idle: cpu26} 11 root 155 ki31 0K 512K CPU20 20 717:10 70.41% idle{idle: cpu20} 11 root 155 ki31 0K 512K CPU28 28 585:04 69.92% idle{idle: cpu28} 11 root 155 ki31 0K 512K CPU27 27 587:26 68.99% idle{idle: cpu27} 11 root 155 ki31 0K 512K CPU18 18 720:27 67.33% idle{idle: cpu18} 11 root 155 ki31 0K 512K CPU22 22 708:13 65.53% idle{idle: cpu22} 11 root 155 ki31 0K 512K CPU30 30 575:57 65.28% idle{idle: cpu30} 11 root 155 ki31 0K 512K CPU19 19 710:14 65.19% idle{idle: cpu19} 11 root 155 ki31 0K 512K CPU16 16 713:54 63.82% idle{idle: cpu16} 11 root 155 ki31 0K 512K RUN 31 546:46 63.77% idle{idle: cpu31} 11 root 155 ki31 0K 512K RUN 17 718:39 63.53% idle{idle: cpu17} 11 root 155 ki31 0K 512K CPU23 23 715:42 62.11% idle{idle: cpu23} 11 root 155 ki31 0K 512K RUN 21 718:10 61.33% idle{idle: cpu21} 11 root 155 ki31 0K 512K RUN 24 539:55 60.16% idle{idle: cpu24} 12 root -92 - 0K 1584K CPU21 21 39:58 41.55% intr{irq271: igb2:que} 12 root -92 - 0K 1584K CPU24 24 229:30 41.06% intr{irq277: igb4:que} 12 root -92 - 0K 1584K CPU19 19 45:16 40.62% intr{irq268: igb1:que} 12 root -92 - 0K 1584K CPU23 23 41:13 37.65% intr{irq274: igb3:que} 12 root -92 - 0K 1584K CPU20 20 39:30 36.67% intr{irq270: igb2:que} 12 root -92 - 0K 1584K CPU17 17 40:04 36.62% intr{irq265: igb0:que} 12 root -92 - 0K 1584K CPU16 16 39:20 36.28% intr{irq264: igb0:que} 12 root -92 - 0K 1584K CPU31 31 223:12 35.89% intr{irq287: igb7:que} 12 root -92 - 0K 1584K CPU22 22 41:00 35.50% intr{irq273: igb3:que} 12 root -92 - 0K 1584K WAIT 30 195:54 35.01% intr{irq286: igb7:que} 12 root -92 - 0K 1584K CPU27 27 189:05 34.08% intr{irq281: igb5:que} 12 root -92 - 0K 1584K CPU18 18 39:30 33.54% intr{irq267: igb1:que} 12 root -92 - 0K 1584K CPU25 25 186:29 33.35% intr{irq278: igb4:que} 12 root -92 - 0K 1584K CPU29 29 193:23 31.15% intr{irq284: igb6:que} 12 root -92 - 0K 1584K WAIT 26 187:59 31.10% intr{irq280: igb5:que} 12 root -92 - 0K 1584K WAIT 28 189:16 30.76% intr{irq283: igb6:que} 11 root 155 ki31 0K 512K RUN 0 572:58 3.61% idle{idle: cpu0} 1420 root 20 -15 91916K 36888K nanslp 15 66:08 2.59% perl 3 root -16 - 0K 16K pftm 10 6:07 0.34% pf purge 55294 root 20 0 21948K 3716K CPU10 10 0:07 0.05% top 0 root -16 - 0K 432K swapin 5 190.3H 0.00% kernel{swapper} И вот как только dummynet упирается в 100%, нагрузка CPU по очередям сетевух тоже начинает расти. Если вообще выключить шейпер, то вообще все прекрасно. Более меннее с узким местом разобрались. Попробую еще с выключенным hyperthreading'ом, но думаю это ситуацию не поменяет. Подскажите как уменьшить нагрузку от dummynet? -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Я не вижу, чтобы pf вел себя неадекватно. Судя по pmcstat он вполне справляется с нагрузкой и проблема явно не в нем. -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Да может и с, но как-то не использовал. А что не так с фряхой? Допустим можно поставть и линукс. Чем там резать скорости? tc? -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Это надо быть в серверной, когда он перегружается :) Выставил 2. Посмотрим сегодня. dummynet прибил к 0. Прерывания сетевух на ядра 16-31. Норм? ) И еще нюанс. Не может это быть из-за lacp? Вчера я уперся ровно в 2.3 Gbit/s. -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Такс.. если в момент нагрузки на сервер добавить правило ipfw 1 allow any to any То видим следующую картину: PMC: [iNSTR_RETIRED_ANY] Samples: 153639 (100.0%) , 0 unresolved %SAMP IMAGE FUNCTION CALLERS 27.7 kernel cpu_search_highest cpu_search_highest:24.8 sched_idletd:2.9 14.5 kernel cpu_search_lowest cpu_search_lowest:13.0 sched_pickcpu:1.5 2.5 kernel ipfw_chk ipfw_check_packet 2.3 kernel _mtx_lock_spin_cooki pmclog_reserve:0.8 tdq_lock_pair:0.7 sched_idletd:0.7 1.8 kernel __rw_rlock 1.8 kernel sched_pickcpu sched_add 1.7 libc.so.7 bsearch 0x6564 1.7 pf.ko pf_test pf_check_in:0.9 pf_check_out:0.8 1.5 kernel ip_input swi_net 1.5 kernel sched_switch mi_switch 1.5 kernel tdq_move sched_idletd 1.5 kernel spinlock_exit 1.4 kernel bcmp pf_find_state 1.3 kernel _rw_runlock_cookie 1.0 kernel bzero 0.9 kernel thread_lock_flags_ 0.9 kernel cpu_switch mi_switch 0.9 kernel igb_rxeof igb_msix_que 0.9 kernel murmur3_aligned_32 pf_find_state 0.8 kernel ithread_loop fork_exit 0.7 kernel critical_exit 0.7 kernel bcopy 0.7 kernel spinlock_enter 0.7 pmcstat 0x657c bsearch При 2гигах трафика. last pid: 60863; load averages: 4.81, 12.71, 16.60 up 1+09:45:15 17:41:11 Если обратно прокускать трафик по фаерволу, то получаем PMC: [iNSTR_RETIRED_ANY] Samples: 273794 (100.0%) , 0 unresolved %SAMP IMAGE FUNCTION CALLERS 25.7 kernel __mtx_lock_sleep dummynet_io 13.4 kernel cpu_search_lowest cpu_search_lowest:12.2 sched_pickcpu:1.3 8.4 kernel cpu_search_highest cpu_search_highest:7.1 sched_idletd:1.3 5.2 kernel ipfw_chk ipfw_check_packet 3.7 kernel rn_match ipfw_lookup_table 3.6 kernel _mtx_lock_spin_cooki turnstile_trywait:1.6 pmclog_reserve:1.2 3.2 kernel fsk_match dn_ht_find 2.3 libc.so.7 bsearch 0x6564 1.3 kernel tdq_move sched_idletd 1.2 pf.ko pf_test pf_check_in 1.0 kernel __rw_rlock 0.8 kernel spinlock_exit 0.8 kernel bcmp pf_find_state 0.8 pmcstat 0x657c bsearch 0.8 kernel ip_input swi_net 0.7 kernel ipfw_lookup_table ipfw_chk 0.7 kernel sched_switch mi_switch 0.7 kernel _rw_runlock_cookie 0.6 kernel murmur3_aligned_32 pf_find_state 0.5 kernel bzero 0.5 kernel sched_pickcpu sched_add И нагрузку соответственно: last pid: 62205; load averages: 26.59, 18.48, 18.17 up 1+09:48:15 17:44:11 Попробую ночью ребутнуть сервер, чтобы уменьшить количество очередей. Ставить 2 или 4? -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Переделал. Ждем нагрузки. 00002 402710575 21041055540 allow ip from 10.4.4.0/23 to any 00003 8607 711300 allow ip from any to 10.4.4.0/23 00011 39086 2857136 deny ip from any to any dst-port 135,137,138,139 00200 15902 3124664 allow ip from any to any via lo0 00300 29385013 20631396098 allow ip from me to any keep-state 00404 690 45448 allow ip from any to me dst-port 1723 01100 9248945 3463856379 allow ip from table(10) to table(10) 01500 30296 14519567 allow ip from table(5) to table(6) 01510 41042 33417482 allow ip from table(6) to table(5) 01600 460243308 202192958613 allow ip from table(5) to table(5) 02000 373662 19011770 deny tcp from not table(99) to any dst-port 25 02100 55107528 47897550128 allow ip from any to any via lagg1 02300 149976721 36153609289 deny ip from any to me 02422 39028824 51455272458 pipe tablearg ip from any to table(11) in recv lagg0 02423 15026478 2980858213 pipe tablearg ip from table(12) to any out xmit lagg0 65535 2167543 207304831 deny ip from any to any -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Пробовал, результата не дало. Попробую потом еще раз. Да и в теории не может он обрабатывать его несколько раз т.к. стоит net.inet.ip.fw.one_pass: 1 Как будет возможность - выключу. Просто рабочая тачка и надо это будет попробовать сделать ночью. На 32ом. Сетевухи по прерыванияем раскинул на первые 16 ядер. А вот это как сделать, подскажите. Сегодня попробую вечером сделать в фаерволе правило allow any to any. Посмотрим изменится ли нагрузка. Вчера перекинул 500 абонентов(~300-400мбит) на другой сервер. Этот начал работать нормально, выжал 2.28Г/c трафика. load averages: был в районе 15-20ти. Причем когда я с ноута тестировал скорость, то спокойно прокачивал по 500мбит на спидтесте. -

freebsd nat dummynet

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Прибит. Что в нем не так? -

Добрый день! Есть сервер: 2xE5-2670 8гигабитных сетевых карт. Пытаюсь занатить и зашейпить более 2Гиг трафа. Упираюсь примерно в 2гига и дальше начинаются дикие лаги. Пока не могу понять, что надо подкрутить. Прошу помощи. Нат PF. Сетевукши собраны в lagg0 и lagg1 по 4 штуки. # uname -a FreeBSD border 10.3-RELEASE-p19 FreeBSD 10.3-RELEASE-p19 #1: Mon Jun 12 21:52:40 EEST 2017 root@border:/usr/src/sys/amd64/compile/ROUTER amd64 # top -CHS last pid: 79595; load averages: 54.17, 39.00, 27.17 up 0+10:10:15 18:06:11 360 processes: 88 running, 194 sleeping, 78 waiting CPU: 2.2% user, 0.0% nice, 2.6% system, 63.0% interrupt, 32.2% idle Mem: 35M Active, 77M Inact, 1413M Wired, 97M Buf, 61G Free Swap: PID USERNAME PRI NICE SIZE RES STATE C TIME CPU COMMAND 12 root -92 - 0K 2096K CPU11 11 70:44 60.30% intr{irq276: igb1:que} 0 root -92 - 0K 1200K RUN 31 299:03 60.06% kernel{dummynet} 12 root -92 - 0K 2096K RUN 14 66:31 57.62% intr{irq279: igb1:que} 12 root -92 - 0K 2096K CPU8 8 69:20 55.13% intr{irq273: igb1:que} 11 root 155 ki31 0K 512K CPU21 21 494:47 54.74% idle{idle: cpu21} 12 root -92 - 0K 2096K RUN 10 69:05 54.54% intr{irq275: igb1:que} 11 root 155 ki31 0K 512K CPU29 29 493:15 51.66% idle{idle: cpu29} 11 root 155 ki31 0K 512K RUN 20 492:37 51.07% idle{idle: cpu20} 12 root -92 - 0K 2096K CPU12 12 64:16 50.05% intr{irq277: igb1:que} 12 root -92 - 0K 2096K CPU3 3 65:16 49.51% intr{irq267: igb0:que} 11 root 155 ki31 0K 512K RUN 17 497:31 49.17% idle{idle: cpu17} 11 root 155 ki31 0K 512K RUN 28 489:10 48.83% idle{idle: cpu28} 12 root -92 - 0K 2096K RUN 6 61:13 48.44% intr{irq270: igb0:que} 12 root -92 - 0K 2096K CPU0 0 63:29 48.34% intr{irq264: igb0:que} 12 root -92 - 0K 2096K WAIT 13 65:50 47.46% intr{irq278: igb1:que} 11 root 155 ki31 0K 512K RUN 26 490:13 47.22% idle{idle: cpu26} 12 root -92 - 0K 2096K CPU15 15 66:59 45.90% intr{irq280: igb1:que} 11 root 155 ki31 0K 512K RUN 23 494:39 45.56% idle{idle: cpu23} 12 root -92 - 0K 2096K CPU2 2 67:21 44.87% intr{irq266: igb0:que} 11 root 155 ki31 0K 512K RUN 22 492:39 43.02% idle{idle: cpu22} 11 root 155 ki31 0K 512K RUN 27 486:35 42.72% idle{idle: cpu27} 12 root -92 - 0K 2096K WAIT 9 61:26 42.48% intr{irq274: igb1:que} 12 root -92 - 0K 2096K RUN 1 61:39 42.04% intr{irq302: igb4:que} 12 root -92 - 0K 2096K WAIT 24 66:45 41.80% intr{irq291: igb3:que} 12 root -92 - 0K 2096K WAIT 13 51:01 41.55% intr{irq315: igb5:que} 12 root -92 - 0K 2096K RUN 18 59:04 41.11% intr{irq284: igb2:que} 12 root -92 - 0K 2096K CPU16 16 58:44 40.87% intr{irq282: igb2:que} 11 root 155 ki31 0K 512K RUN 25 473:50 40.62% idle{idle: cpu25} 11 root 155 ki31 0K 512K RUN 19 493:52 40.19% idle{idle: cpu19} 11 root 155 ki31 0K 512K RUN 30 450:00 40.14% idle{idle: cpu30} 12 root -92 - 0K 2096K CPU1 1 67:57 39.89% intr{irq265: igb0:que} 11 root 155 ki31 0K 512K CPU16 16 489:48 39.70% idle{idle: cpu16} 12 root -92 - 0K 2096K CPU7 7 62:06 39.40% intr{irq271: igb0:que} 12 root -92 - 0K 2096K WAIT 30 61:26 39.40% intr{irq297: igb3:que} 12 root -92 - 0K 2096K CPU22 22 60:03 39.31% intr{irq288: igb2:que} 11 root 155 ki31 0K 512K CPU24 24 481:14 38.67% idle{idle: cpu24} 12 root -92 - 0K 2096K RUN 12 54:41 38.38% intr{irq314: igb5:que} 12 root -92 - 0K 2096K CPU19 19 59:30 38.18% intr{irq285: igb2:que} 12 root -92 - 0K 2096K WAIT 25 68:20 37.89% intr{irq292: igb3:que} 12 root -92 - 0K 2096K RUN 0 49:44 37.16% intr{irq301: igb4:que} 12 root -92 - 0K 2096K RUN 8 50:10 37.01% intr{irq310: igb5:que} 11 root 155 ki31 0K 512K RUN 18 496:30 36.87% idle{idle: cpu18} 12 root -92 - 0K 2096K RUN 2 48:33 36.43% intr{irq303: igb4:que} 12 root -92 - 0K 2096K RUN 4 67:04 36.28% intr{irq268: igb0:que} 12 root -92 - 0K 2096K RUN 5 61:12 35.64% intr{irq269: igb0:que} # pmcstat -TS instructions -w1 PMC: [iNSTR_RETIRED_ANY] Samples: 227668 (100.0%) , 0 unresolved %SAMP IMAGE FUNCTION CALLERS 25.1 kernel cpu_search_highest cpu_search_highest:23.0 sched_idletd:2.1 18.2 kernel __mtx_lock_sleep dummynet_io:17.0 rtalloc1_fib:0.6 ip_fastforward:0.6 6.4 kernel ipfw_chk ipfw_check_packet 4.7 kernel rn_match ipfw_lookup_table:4.2 rtalloc1_fib:0.5 3.8 kernel tdq_move sched_idletd 3.3 kernel fsk_match dn_ht_find 2.8 kernel cpu_search_lowest cpu_search_lowest 2.1 libc.so.7 bsearch 0x6564 1.4 kernel bcmp pf_find_state 1.3 kernel __rw_rlock 1.2 kernel _mtx_lock_spin_cooki pmclog_reserve 1.2 pf.ko pf_test pf_check_in:0.6 pf_check_out:0.6 0.9 kernel ipfw_lookup_table ipfw_chk 0.9 kernel _rw_runlock_cookie 0.9 pmcstat 0x657c bsearch 0.8 kernel bzero 0.7 kernel dn_ht_find dummynet_io 0.7 kernel spinlock_exit 0.6 kernel murmur3_aligned_32 pf_find_state 0.6 kernel tdq_lock_pair sched_idletd 0.5 kernel ip_fastforward ether_demux 0.5 kernel _rm_rlock # cat /boot/loader.conf pf_load="YES" hw.igb.rxd=4096 hw.igb.txd=4096 hw.igb.max_interrupt_rate=32000 kern.ipc.maxsockbuf=16777216 # kernel socket buffer space kern.ipc.nmbclusters=4072804 # kernel mbuf space raised 275MB of kernel dedicated ram kern.ipc.somaxconn=32768 # size of the listen queue for accepting new TCP connections kern.ipc.maxsockets=2091460 # increase the limit of the open sockets net.inet.tcp.tcbhashsize=32768 net.isr.defaultqlimit=4096 net.isr.bindthreads=1 net.isr.maxthreads=16 net.link.ifqmaxlen=1024 # cat /etc/sysctl.conf net.inet.ip.fw.dyn_max=32768 kern.ipc.somaxconn=32768 net.inet.ip.dummynet.io_fast=1 net.inet.tcp.blackhole=2 net.inet.udp.blackhole=1 net.inet.icmp.drop_redirect=1 net.inet.ip.redirect=0 net.inet.tcp.delayed_ack=0 net.inet.tcp.drop_synfin=1 net.inet.icmp.icmplim=1000 # Dummy net.inet.ip.dummynet.io_fast=1 # def 0 (1 - tuning) net.inet.ip.dummynet.pipe_slot_limit=4096 # def 100 (2048 or 4096 - tuning) net.inet.ip.dummynet.hash_size=65535 # def 64 (65535 - tuning) net.inet.ip.dummynet.expire=0 # def 1 (0 - tuning) net.inet.ip.fastforwarding=1 net.inet.ip.portrange.randomized=0 net.inet.ip.fw.dyn_buckets=2048 net.inet.ip.intr_queue_maxlen=8192 net.inet.ip.intr_queue_maxlen=256 net.inet.ip.maxfragpackets=1024 net.inet.tcp.fast_finwait2_recycle=1 net.inet.tcp.finwait2_timeout=3000 net.inet.tcp.hostcache.expire=1200 net.inet.tcp.keepinit=5000 net.inet.tcp.maxtcptw=65536 net.inet.tcp.msl=5000 dev.igb.0.rx_processing_limit=4096 dev.igb.1.rx_processing_limit=4096 dev.igb.2.rx_processing_limit=4096 dev.igb.3.rx_processing_limit=4096 dev.igb.4.rx_processing_limit=4096 dev.igb.5.rx_processing_limit=4096 dev.igb.6.rx_processing_limit=4096 dev.igb.7.rx_processing_limit=4096 # vmstat -i interrupt total rate irq9: acpi0 5235 0 irq19: ehci0 64762 1 irq23: ehci1 157417 3 cpu0:timer 175605023 4094 irq264: igb0:que 0 228522805 5328 irq265: igb0:que 1 248072541 5784 irq266: igb0:que 2 174069260 4058 irq267: igb0:que 3 167833607 3913 irq268: igb0:que 4 172548846 4023 irq269: igb0:que 5 203273719 4739 irq270: igb0:que 6 172410453 4020 irq271: igb0:que 7 173611237 4048 irq272: igb0:link 4 0 irq273: igb1:que 0 180331163 4204 irq274: igb1:que 1 226358159 5278 irq275: igb1:que 2 173719240 4050 irq276: igb1:que 3 245557570 5725 irq277: igb1:que 4 240788330 5614 irq278: igb1:que 5 197578439 4607 irq279: igb1:que 6 242163590 5646 irq280: igb1:que 7 208878854 4870 irq281: igb1:link 6 0 irq282: igb2:que 0 173827872 4053 irq283: igb2:que 1 192415493 4486 irq284: igb2:que 2 257450688 6003 irq285: igb2:que 3 191369836 4462 irq286: igb2:que 4 173988770 4057 irq287: igb2:que 5 185143401 4317 irq288: igb2:que 6 254996181 5946 irq289: igb2:que 7 173072381 4035 irq290: igb2:link 6 0 irq291: igb3:que 0 192835011 4496 irq292: igb3:que 1 277756652 6476 irq293: igb3:que 2 178887078 4171 irq294: igb3:que 3 182217517 4248 irq295: igb3:que 4 184297873 4297 irq296: igb3:que 5 168691387 3933 irq297: igb3:que 6 167597246 3908 irq298: igb3:que 7 149144287 3477 irq299: igb3:link 5 0 irq300: mfi0 23850 0 irq301: igb4:que 0 221577696 5166 irq302: igb4:que 1 265119356 6182 irq303: igb4:que 2 249947999 5828 irq304: igb4:que 3 171594047 4001 irq305: igb4:que 4 171047771 3988 irq306: igb4:que 5 168220031 3922 irq307: igb4:que 6 227082007 5295 irq308: igb4:que 7 251052728 5854 irq309: igb4:link 4 0 irq310: igb5:que 0 173366626 4042 irq311: igb5:que 1 172353573 4018 irq312: igb5:que 2 243125420 5669 irq313: igb5:que 3 168234188 3922 irq314: igb5:que 4 172763177 4028 irq315: igb5:que 5 208390970 4859 irq316: igb5:que 6 208249253 4855 irq317: igb5:que 7 167868167 3914 irq318: igb5:link 5 0 irq319: igb6:que 0 191137495 4456 irq320: igb6:que 1 179951384 4196 irq321: igb6:que 2 177218181 4132 irq322: igb6:que 3 174318360 4064 irq323: igb6:que 4 178746969 4168 irq324: igb6:que 5 174453770 4067 irq325: igb6:que 6 178751539 4168 irq326: igb6:que 7 177087733 4129 irq327: igb6:link 5 0 irq328: igb7:que 0 259734537 6056 irq329: igb7:que 1 228815047 5335 irq330: igb7:que 2 175103386 4083 irq331: igb7:que 3 272089502 6344 irq332: igb7:que 4 173298242 4040 irq333: igb7:que 5 179091805 4176 irq334: igb7:que 6 175887823 4101 irq335: igb7:que 7 152749381 3561 irq336: igb7:link 5 0 irq337: ahci0 23 0 cpu31:timer 155525124 3626 cpu13:timer 159030857 3708 cpu30:timer 149633327 3489 cpu9:timer 154773922 3609 cpu29:timer 150983104 3520 cpu12:timer 158079353 3686 cpu25:timer 164213916 3829 cpu11:timer 158419003 3694 cpu21:timer 155878091 3634 cpu10:timer 161772579 3772 cpu27:timer 163334315 3808 cpu4:timer 153022948 3568 cpu20:timer 152385871 3553 cpu7:timer 157437062 3671 cpu28:timer 153664471 3583 cpu5:timer 155690855 3630 cpu24:timer 162140834 3780 cpu6:timer 155124554 3617 cpu26:timer 153247929 3573 cpu2:timer 160839398 3750 cpu19:timer 159561669 3720 cpu8:timer 155063933 3615 cpu18:timer 158926502 3705 cpu15:timer 157587246 3674 cpu17:timer 157507663 3672 cpu14:timer 156166934 3641 cpu23:timer 151140656 3524 cpu3:timer 153875639 3588 cpu22:timer 160017963 3731 cpu16:timer 155875229 3634 cpu1:timer 161608126 3768 Total 17686223072 412410 # vmstat -z ITEM SIZE LIMIT USED FREE REQ FAIL SLEEP UMA Kegs: 384, 0, 117, 3, 117, 0, 0 UMA Zones: 4736, 0, 117, 0, 117, 0, 0 UMA Slabs: 80, 0, 7679, 21, 8209, 0, 0 UMA RCntSlabs: 88, 0, 153684, 36, 153684, 0, 0 UMA Hash: 256, 0, 1, 14, 8, 0, 0 4 Bucket: 32, 0, 307, 8818, 79568, 0, 0 6 Bucket: 48, 0, 0, 0, 0, 0, 0 8 Bucket: 64, 0, 87, 9337, 111492, 16, 0 12 Bucket: 96, 0, 187, 3831, 273921, 0, 0 16 Bucket: 128, 0, 369, 3661, 284142, 0, 0 32 Bucket: 256, 0, 552, 2748, 462448, 54, 0 64 Bucket: 512, 0, 1831, 1281, 818505, 85, 0 128 Bucket: 1024, 0, 751, 665, 702552, 0, 0 256 Bucket: 2048, 0, 1742, 1600,25006661, 27, 0 vmem btag: 56, 0, 13378, 4869, 13378, 133, 0 VM OBJECT: 256, 0, 3189, 2556, 8354436, 0, 0 RADIX NODE: 144, 0, 9897, 2982,30930147, 0, 0 MAP: 240, 0, 3, 61, 3, 0, 0 KMAP ENTRY: 128, 0, 18, 881, 18, 0, 0 MAP ENTRY: 128, 0, 2537, 5616,39481004, 0, 0 VMSPACE: 448, 0, 46, 1295, 320812, 0, 0 fakepg: 104, 0, 0, 0, 0, 0, 0 mt_zone: 4112, 0, 388, 0, 388, 0, 0 16: 16, 0, 5638, 7916, 1153450, 0, 0 32: 32, 0, 6722, 12778, 5191597, 0, 0 64: 64, 0, 14265, 9543, 3556275, 0, 0 128: 128, 0, 16770, 3504, 143971, 0, 0 256: 256, 0, 37055, 16314,11684483911, 0, 0 512: 512, 0, 16882, 1510, 318308, 0, 0 1024: 1024, 0, 552, 504, 1112275, 0, 0 2048: 2048, 0, 172, 244, 325429, 0, 0 4096: 4096, 0, 1485, 52, 325489, 0, 0 8192: 8192, 0, 33, 31, 954, 0, 0 16384: 16384, 0, 19, 10, 1224, 0, 0 32768: 32768, 0, 10, 44, 1371, 0, 0 65536: 65536, 0, 132, 4, 452, 0, 0 SLEEPQUEUE: 80, 0, 982, 3296, 982, 0, 0 64 pcpu: 8, 0, 3974, 6010, 6521, 0, 0 Files: 80, 0, 145, 4755, 3438479, 0, 0 TURNSTILE: 136, 0, 982, 1278, 982, 0, 0 rl_entry: 40, 0, 635, 7465, 635, 0, 0 umtx pi: 96, 0, 0, 0, 0, 0, 0 MAC labels: 40, 0, 0, 0, 0, 0, 0 PROC: 1264, 0, 63, 333, 320841, 0, 0 THREAD: 1192, 0, 693, 288, 2392, 0, 0 cpuset: 72, 0, 309, 1946, 405, 0, 0 audit_record: 1248, 0, 0, 0, 0, 0, 0 mbuf_packet: 256, 26065950, 262619, 44523,12055761451, 0, 0 mbuf: 256, 26065950, 2, 12911,574940424, 0, 0 mbuf_cluster: 2048, 4072804, 307142, 174, 307142, 0, 0 mbuf_jumbo_page: 4096, 2036401, 0, 26, 2058, 0, 0 mbuf_jumbo_9k: 9216, 603378, 0, 0, 0, 0, 0 mbuf_jumbo_16k: 16384, 339400, 0, 0, 0, 0, 0 mbuf_ext_refcnt: 4, 0, 0, 0, 0, 0, 0 g_bio: 248, 0, 0, 2016, 72080, 0, 0 ttyinq: 160, 0, 420, 1105, 1155, 0, 0 ttyoutq: 256, 0, 219, 1311, 601, 0, 0 DMAR_MAP_ENTRY: 120, 0, 0, 0, 0, 0, 0 nvme_request: 128, 0, 0, 0, 0, 0, 0 vtnet_tx_hdr: 24, 0, 0, 0, 0, 0, 0 FPU_save_area: 832, 0, 0, 0, 0, 0, 0 VNODE: 472, 0, 1203, 653, 3278, 0, 0 VNODEPOLL: 112, 0, 1, 139, 1, 0, 0 BUF TRIE: 144, 0, 136, 105812, 15311, 0, 0 S VFS Cache: 108, 0, 1205, 3310, 11454, 0, 0 STS VFS Cache: 148, 0, 0, 0, 0, 0, 0 L VFS Cache: 328, 0, 1, 35, 1, 0, 0 LTS VFS Cache: 368, 0, 0, 0, 0, 0, 0 NAMEI: 1024, 0, 0, 508, 6843396, 0, 0 NCLNODE: 528, 0, 0, 0, 0, 0, 0 DIRHASH: 1024, 0, 76, 120, 76, 0, 0 pipe: 744, 0, 11, 484, 318154, 0, 0 procdesc: 128, 0, 0, 0, 0, 0, 0 Mountpoints: 816, 0, 6, 24, 6, 0, 0 ksiginfo: 112, 0, 388, 4127, 2891, 0, 0 itimer: 352, 0, 0, 0, 0, 0, 0 pf mtags: 40, 0, 0, 7100, 2238, 0, 0 pf states: 296, 1000012, 227626, 67266,102987716, 0, 0 pf state keys: 88, 0, 455355, 138240,205991974, 0, 0 pf source nodes: 136, 400026, 0, 0, 0, 0, 0 pf table entries: 160, 1000000, 0, 0, 0, 0, 0 pf table counters: 64, 0, 0, 0, 0, 0, 0 pf frags: 120, 0, 0, 0, 0, 0, 0 pf frag entries: 40, 1000000, 0, 0, 0, 0, 0 pf state scrubs: 40, 0, 0, 0, 0, 0, 0 KNOTE: 128, 0, 0, 5394,95695621, 0, 0 socket: 696, 2091460, 55, 480, 526792, 0, 0 unpcb: 240, 2091472, 18, 1934, 4889, 0, 0 ipq: 56, 1065, 0, 0, 0, 0, 0 udp_inpcb: 392, 2091460, 8, 982, 204322, 0, 0 udpcb: 24, 2091508, 8, 8175, 204322, 0, 0 tcp_inpcb: 392, 2091460, 20, 800, 276, 0, 0 tcpcb: 1032, 2091462, 20, 232, 276, 0, 0 tcptw: 88, 65565, 0, 3015, 185, 0, 0 syncache: 160, 15375, 0, 1975, 87, 0, 0 hostcache: 136, 15370, 2, 636, 16, 0, 0 sackhole: 32, 0, 0, 1375, 43, 0, 0 tcpreass: 40, 254600, 0, 3300, 1029, 0, 0 sctp_ep: 1424, 2091460, 0, 0, 0, 0, 0 sctp_asoc: 2416, 40000, 0, 0, 0, 0, 0 sctp_laddr: 48, 80012, 0, 3818, 25, 0, 0 sctp_raddr: 728, 80000, 0, 0, 0, 0, 0 sctp_chunk: 136, 400026, 0, 0, 0, 0, 0 sctp_readq: 104, 400026, 0, 0, 0, 0, 0 sctp_stream_msg_out: 104, 400026, 0, 0, 0, 0, 0 sctp_asconf: 40, 400000, 0, 0, 0, 0, 0 sctp_asconf_ack: 48, 400060, 0, 0, 0, 0, 0 udplite_inpcb: 392, 2091460, 0, 0, 0, 0, 0 ripcb: 392, 2091460, 2, 1108, 317132, 0, 0 rtentry: 200, 0, 22, 898, 57, 0, 0 IPFW dynamic rule: 120, 32769, 17, 4372, 96668, 0, 0 divcb: 392, 2091460, 0, 0, 0, 0, 0 selfd: 56, 0, 450, 9206, 3530881, 0, 0 SWAPMETA: 288, 8145605, 0, 0, 0, 0, 0 FFS inode: 176, 0, 1160, 1480, 3224, 0, 0 FFS1 dinode: 128, 0, 0, 0, 0, 0, 0 FFS2 dinode: 256, 0, 1160, 1465, 3224, 0, 0 NetGraph items: 72, 4123, 0, 4123, 4806796, 0, 0 NetGraph data items: 72, 4123, 0, 4123, 8610071, 0, 0 # netstat -m 262697/57358/320055 mbufs in use (current/cache/total) 262695/44621/307316/4072804 mbuf clusters in use (current/cache/total/max) 262695/44447 mbuf+clusters out of packet secondary zone in use (current/cache) 0/26/26/2036401 4k (page size) jumbo clusters in use (current/cache/total/max) 0/0/0/603378 9k jumbo clusters in use (current/cache/total/max) 0/0/0/339400 16k jumbo clusters in use (current/cache/total/max) 591177K/103685K/694863K bytes allocated to network (current/cache/total) 0/0/0 requests for mbufs denied (mbufs/clusters/mbuf+clusters) 0/0/0 requests for mbufs delayed (mbufs/clusters/mbuf+clusters) 0/0/0 requests for jumbo clusters delayed (4k/9k/16k) 0/0/0 requests for jumbo clusters denied (4k/9k/16k) 0 requests for sfbufs denied 0 requests for sfbufs delayed 0 requests for I/O initiated by sendfile Ну и с чем собрал ядро: options IPFIREWALL options IPDIVERT options DUMMYNET options HZ=4000 device lagg # ipfw show 00002 186071167 9740189392 allow ip from 10.4.4.0/23 to any 00003 4013 308348 allow ip from any to 10.4.4.0/23 00011 21185 1522561 deny ip from any to any dst-port 135,137,138,139 00200 7378 1455753 allow ip from any to any via lo0 00300 16123904 11718399318 allow ip from me to any keep-state 00404 242 15780 allow ip from any to me dst-port 1723 01100 7026180 2648585449 allow ip from table(10) to table(10) 01500 27540 13919779 allow ip from table(5) to table(6) 01510 36876 29904352 allow ip from table(6) to table(5) 01600 253360944 113478412229 allow ip from table(5) to table(5) 02000 117566 6006818 deny tcp from not table(99) to any dst-port 25 02300 1181 72803 deny ip from any to me 02400 11826233927 9941651138504 allow ip from any to any via lagg0 02500 6955085248 8872500622376 pipe tablearg ip from any to table(11) 02600 4649002652 1058448911252 pipe tablearg ip from table(12) to any 65535 1381522 155850741 deny ip from any to any # ipfw pipe list | grep burst | wc -l 9692 # ifconfig lagg0: flags=8843<UP,BROADCAST,RUNNING,SIMPLEX,MULTICAST> metric 0 mtu 1500 options=400bb<RXCSUM,TXCSUM,VLAN_MTU,VLAN_HWTAGGING,JUMBO_MTU,VLAN_HWCSUM,VLAN_HWTSO> ether 00:1b:21:61:9f:e0 inet xxx.xxx.xxx.xxx netmask 0xffffff00 broadcast xxx.xxx.xxx.255 nd6 options=29<PERFORMNUD,IFDISABLED,AUTO_LINKLOCAL> media: Ethernet autoselect status: active laggproto lacp lagghash l2,l3,l4 laggport: igb0 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING> laggport: igb1 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING> laggport: igb2 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING> laggport: igb3 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING> lagg1: flags=8843<UP,BROADCAST,RUNNING,SIMPLEX,MULTICAST> metric 0 mtu 1500 options=400bb<RXCSUM,TXCSUM,VLAN_MTU,VLAN_HWTAGGING,JUMBO_MTU,VLAN_HWCSUM,VLAN_HWTSO> ether 40:f2:e9:0c:3d:0c inet 172.16.21.4 netmask 0xffffff00 broadcast 172.16.21.255 nd6 options=29<PERFORMNUD,IFDISABLED,AUTO_LINKLOCAL> media: Ethernet autoselect status: active laggproto lacp lagghash l2,l3,l4 laggport: igb4 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING> laggport: igb5 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING> laggport: igb6 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING> laggport: igb7 flags=1c<ACTIVE,COLLECTING,DISTRIBUTING>

-

Tacacs Huawei MA5608t

тему ответил в Avad0n пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Удалось ли как-то решить эту проблему, кроме как указывать в логине домен? -

Alcatel LS6224 + radius

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Так указано же Cisco-AVPair = "shell:priv-lvl=15" -

Alcatel LS6224 + radius

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

FreeRADIUS Version 2.2.9 -

Добрый день! Пытаюсь подружить алькательку и радиус. В настройках алькателя: radius-server host w.x.y.z timeout 5 key xxxxxxx aaa authentication login default radius local Лог радиуса: Но алькател отказывается пускать в систему. Что предпринять?

-

IPTV juniper cisco pim

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Решено. -

IPTV juniper cisco pim

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Апнем вопрос. И так. Есть mbgp+msdp. Все установлено, все маршруты я получаю. > show msdp peer 172.16.24.185 Peer address Local address State Last up/down Peer-Group SA Count 172.16.24.185 172.16.24.186 Established 03:05:55 350/350 > show bgp summary group MBGP Groups: 8 Peers: 14 Down peers: 0 Table Tot Paths Act Paths Suppressed History Damp State Pending inet.0 596163 596161 0 0 0 0 inet.2 16 16 0 0 0 0 Peer AS InPkt OutPkt OutQ Flaps Last Up/Dwn State|#Active/Received/Accepted/Damped... 172.16.24.185 35297 364 396 0 0 3:00:33 Establ inet.2: 16/16/16/0 Пытаюсь все это отдать по пим или по igmp в влане 1955, но ничего не выходит. > show configuration protocols pim rib-group inet mcast-rib; assert-timeout 5; rp { local { address 10.1.1.1; priority 5; hold-time 200; group-ranges { 239.0.0.0/23; } } static { address 10.1.1.1 { group-ranges { 239.0.0.0/23; } } } } interface fxp0.0 { disable; } interface all { disable; } interface ge-1/0/0.1955 { mode sparse; version 2; } > show configuration protocols igmp interface all { disable; } interface ge-1/0/0.1955 { version 2; static { group 239.0.0.1 { group-count 500; } } } interface xe-0/0/3.137 { version 2; static { group 239.0.0.1 { group-count 500; } } } Куда рыть? -

IPTV juniper cisco pim

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Указал, поднял. Потока нет) -

IPTV juniper cisco pim

тему ответил в serg_sk пользователя serg_sk в Активное оборудование Ethernet, IP, MPLS, SDN/NFV...

Сменили vlan и интерфейсную пару - все заработало. Теперь есть еще вопрос. Есть еще один поток, который я получаю по mbgp+msdp. Подскажите как мне его принять и раздать дальше по pim'у? )